A essa altura, você provavelmente sabe que companhias como Google e Facebook estão investindo pesado em reconhecimento de imagens. As tecnologias atuais já podem identificar rostos e descrever objetos encontrados nas fotos, por exemplo. A Microsoft, outra gigante que vem levando o assunto bem a sério, já está na fase de se preocupar com o contexto: a empresa criou um sistema de redes neurais que tenta descrever o que está acontecendo em uma imagem da forma como nós faríamos.

O reconhecimento de imagens é mais importante do que parece. Serviços como Google Photos e Flickr contam com tecnologias que tentam nos livrar da tarefa de organizar fotos manualmente ou de classificá-las com tags para facilitar a busca. No Facebook, como você deve saber, o reconhecimento de rostos nos ajuda a marcar os contatos que saíram nas nossas fotos.

Mas a turma de Mark Zuckerberg não parou por aí. No início do mês, a companhia anunciou uma tecnologia que é capaz de analisar fotos e criar legendas para elas automaticamente. O objetivo é descrever as imagens do feed de notícias para usuários com deficiência visual. Não é por menos: a companhia estima que 39 milhões de participantes da rede social são cegos ou têm dificuldades severas para enxergar.

Uma ideia nobre, não? Mas há um percalço aqui: ao menos por enquanto, esse sistema é capaz de descrever objetos na imagem, mas não é muito preciso na contextualização. O sistema pode, por exemplo, descrever uma foto como “a imagem aparenta mostrar três pessoas sorrindo ao ar livre”, mas não aponta se os indivíduos estão na rua, no parque, enfim.

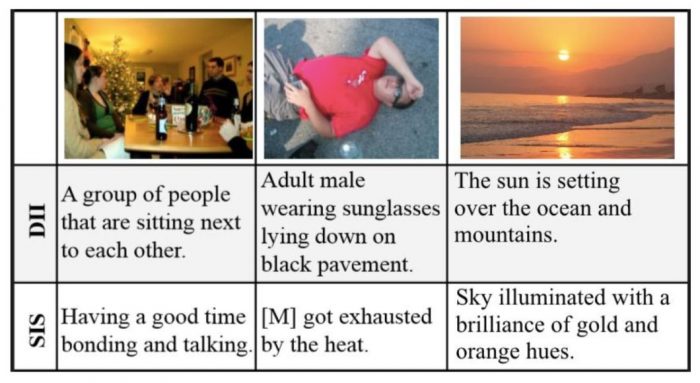

Membros da Microsoft Research se uniram com pesquisadores de várias universidades dos Estados Unidos — e até com um especialista em inteligência artificial do Facebook — para superar esse tipo de limitação: a ideia é fazer o algoritmo descrever a “história” que a imagem conta. Nesse sentido, os pesquisadores preferem usar esse termo, história, no lugar de “descrição” ou “legenda” para explicar o que a tecnologia faz.

Frank Ferraro, pesquisador da Universidade Johns Hopkins e um dos autores do projeto, dá um exemplo: um álbum de fotos mostra pessoas bebendo em um bar; em uma das imagens posteriores, alguém acabou deitando no sofá. Um sistema de legendas automáticas provavelmente descreverá a cena com algo como “há uma pessoa deitada no sofá”. O sistema da Microsoft Research, porém, poderá analisar as fotos anteriores (da turma bebendo) e legendar a imagem como “esta pessoa provavelmente está bêbada”.

É difícil fazer isso. Nós temos uma capacidade incrível de identificar ou imaginar o contexto de fotos porque nos baseamos em uma série de parâmetros: expressões faciais, experiências em ambientes semelhantes, lembranças de lugares e assim por diante. Mesmo assim, há situações em que não conseguimos entender exatamente o que se passa porque as informações que nos ajudariam com o contexto são insuficientes.

Aí está a razão para o sistema da Microsoft Research funcionar melhor com grupos de imagens. Em vez de gerar um resultado específico para cada foto, o algoritmo considera o que foi identificado nas outras imagens para reforçar a base de parâmetros. Assim, um objeto que aparece apenas em determinadas fotos pode ajudar a explicar o que acontece em outras.

Para exemplificar, a foto no início do post foi descrita da seguinte forma: “foi o primeiro aniversário do bebê”. Veja como ficaram as legendas automáticas geradas para outras imagens do mesmo álbum (em tradução livre):

Como você deve ter imaginado, essa é só uma parte do trabalho. Os pesquisadores tiveram que treinar o sistema, que é constituído por redes neurais profundas (tipo que vem sendo usado para reconhecimento de voz e tradução de textos), com sequências de imagens extraídas do Flickr. Participantes do Mechanical Turk, site de crowdsourcing da Amazon, foram contratados para criar legendas individuais e sequenciais de forma a montar a base para o treinamento do algoritmo.

Na fase seguinte, o sistema foi alimentado com novas imagens para descrevê-las com base no conhecimento obtido com o treino. Para validar as descrições, os pesquisadores as compararam com legendas das mesmas fotos feitas por pessoas. O resultado final foi bastante convincente.

Esse projeto está apenas na fase inicial, porém. É necessário mais treinos e aperfeiçoamentos para que ele se torne realmente útil. Mesmo que fique mais evoluído, o sistema não deverá ser completamente preciso na contextualização de imagens (novamente, nem nós somos). Mas, se associado a algoritmos que reconhecem lugares, por exemplo, imagine quão longe as ferramentas de descrição automática de imagens poderão ir.

Com informações: MIT Technology Review, VentureBeat

![Como ativar o Office [2013, 2016, 2019, 2021 ou Microsoft 365]](https://files.tecnoblog.net/wp-content/uploads/2021/11/microsoft-office-word-ldtcqxgycl4-unsplash-340x191.jpg)

![Como jogar Microsoft Flight Simulator [Guia para Iniciantes]](https://files.tecnoblog.net/wp-content/uploads/2020/12/como-jogar-flight-simulator-340x191.jpg)

![Como acessar o Microsoft Teams sem baixar o aplicativo [Navegador]](https://files.tecnoblog.net/wp-content/uploads/2021/03/Como-acessar-o-Microsoft-Teams-sem-baixar-o-aplicativo-Navegador-chris-barbalis-unsplash-340x191.jpg)